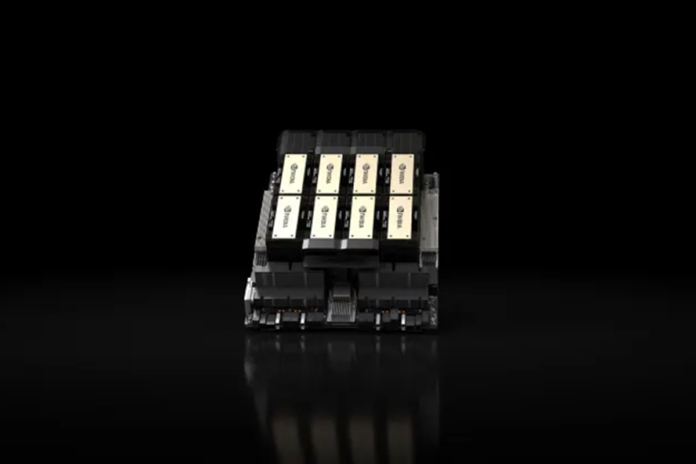

Nvidia ha presentato l’H200, un’unità di elaborazione grafica progettata per l’addestramento e l’implementazione dei tipi di modelli di intelligenza artificiale che stanno alimentando il boom dell’IA generativa.

La nuova GPU è un aggiornamento dall’H100, il chip OpenAI utilizzato per addestrare il suo modello di linguaggio di grandi dimensioni più avanzato, GPT-4. Grandi aziende, startup e agenzie governative sono tutte in lizza per un’offerta limitata di chip.

I chip H100 costano tra i 25.000 e i 40.000 dollari, secondo una stima di Raymond James, e migliaia di loro che lavorano insieme sono necessari per creare i modelli più grandi in un processo chiamato “formazione”.

L’eccitazione per le GPU AI di Nvidia ha sovralimentato le azioni dell’azienda, che sono in aumento di oltre il 230% finora nel 2023. Nvidia si aspetta circa 16 miliardi di dollari di entrate per il suo terzo trimestre fiscale, in aumento del 170% rispetto a un anno fa.

Il miglioramento chiave con l’H200 è che include 141 GB di memoria “HBM3” di nuova generazione che aiuterà il chip utilizzando un modello di grandi dimensioni dopo essere stato addestrato per generare testo, immagini o previsioni. Nvidia ha detto che l’H200 genererà un output quasi due volte più veloce dell’H100. L’H200, potrebbe essere spedito nel secondo trimestre del 2024, competerà con la GPU MI300X di AMD. Nvidia ha detto che l’H200 sarà compatibile con l’H100, il che significa che le aziende di intelligenza artificiale che si stanno già allenando con il modello precedente non avranno bisogno di cambiare i loro sistemi server o software per utilizzare la nuova versione.